robots.txt 文件禁止搜索引擎蜘蛛抓取网站内容

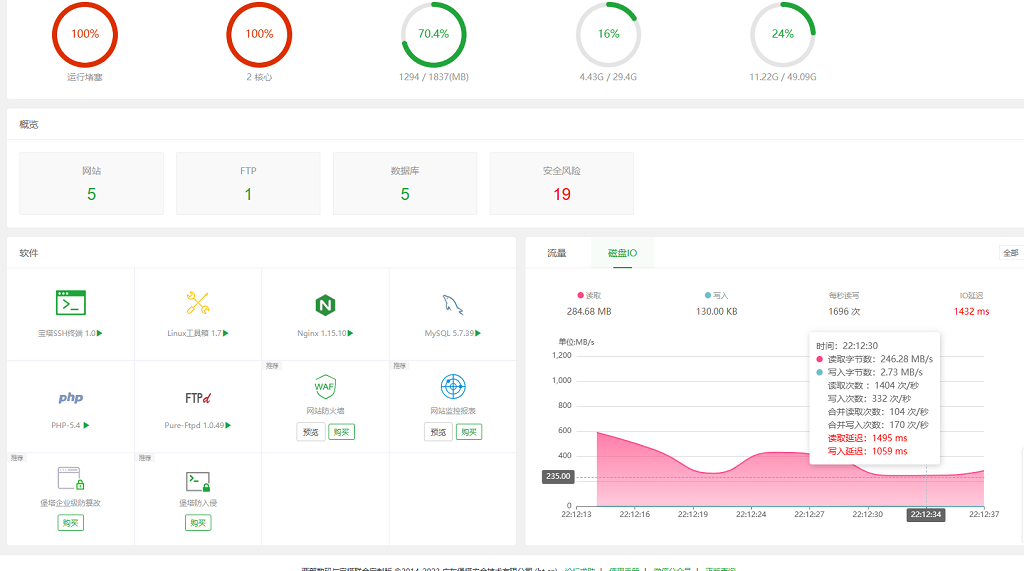

yun发布于3年前 (2023-05-30) 931 浏览 0 评论最近一直服务器爆红,经过排查发现大量垃圾蜘蛛频繁抓紧网站页面,白白浪费服务器资源,所以决定用robots把这些蜘蛛全部屏蔽。

1、什么是robots.txt文件?

搜索引擎通过一种程序robot(又称spider),自动访问互联网上的网页并获取网页信息。

您可以在您的网站中创建一个纯文本文件robots.txt,在这个文件中声明该网站中不想被robot访问的部分,这样,该网站的部分或全部内容就可以不被搜索引擎收录了,或者指定搜索引擎只收录指定的内容。

2、robots.txt文件放在哪里?

robots.txt文件应该放在网站根目录下。举例来说,当robots访问一个网站(比如http://www.abc.com)时,首先会检查该网站中是否存在http://www.abc.com/robots.txt这个文件,如果机器人找到这个文件,它就会根据这个文件的内容,来确定它访问权限的范围。 可以在robots中加入如下代码(代码根据自己需求自行调整):

User-agent:Googlebot Disallow:/ User-agent: AhrefsBot Disallow: / User-agent: DotBot Disallow: / User-agent: SemrushBot Disallow: / User-agent: Uptimebot Disallow: / User-agent: MJ12bot Disallow: / User-agent: MegaIndex.ru Disallow: / User-agent: ZoominfoBot Disallow: / User-agent: Mail.Ru Disallow: / User-agent: SeznamBot Disallow: / User-agent: BLEXBot Disallow: / User-agent: ExtLinksBot Disallow: / User-agent: aiHitBot Disallow: / User-agent: Researchscan Disallow: / User-agent: DnyzBot Disallow: / User-agent: spbot Disallow: / User-agent: YandexBot Disallow: /

以下是垃圾蜘蛛列表:

SemrushBot:这是semrush下面的一个蜘蛛,是一家做搜索引擎优化的公司,因此它抓取网页的目的就很明显了。这种蜘蛛对网站没有任何用处,好在它还遵循robots协议,因此可以直接在robots屏蔽。

DotBot:这是moz旗下的,作用是提供seo服务的蜘蛛,但是对我们并没有什么用处。好在遵循robots协议,可以使用robots屏蔽

AhrefsBot: 这是ahrefs旗下的蜘蛛,作用是提供seo服务,对我们没有任何用处,遵循robots协议。

MJ12bot:这是英国的一个搜索引擎蜘蛛,但是对中文站站点就没有用处了,遵循robots协议。

MauiBot:这个不太清楚是什么,但是有时候很疯狂,好在遵循robots协议。

MegaIndex.ru:这是一个提供反向链接查询的网站的蜘蛛,因此它爬网站主要是分析链接,并没有什么作用。遵循robots协议。

BLEXBot:这个是webmeup下面的蜘蛛,作用是收集网站上面的链接,对我们来说并没有用处。遵循robots协议

robots.txt文件用法举例

例1. 禁止所有搜索引擎访问网站的任何部分

User-agent: *

Disallow: /

例2. 允许所有的robot访问 (或者也可以建一个空文件 "/robots.txt" file)

User-agent: *

Disallow:

例3. 禁止某个搜索引擎的访问

User-agent: BadBot

Disallow: /

例4. 允许某个搜索引擎的访问

User-agent: baiduspider

Disallow:

滇公网安备53010202002139号

滇公网安备53010202002139号

本文暂时没有评论,来添加一个吧(●'◡'●)

取消回复欢迎 你 发表评论: